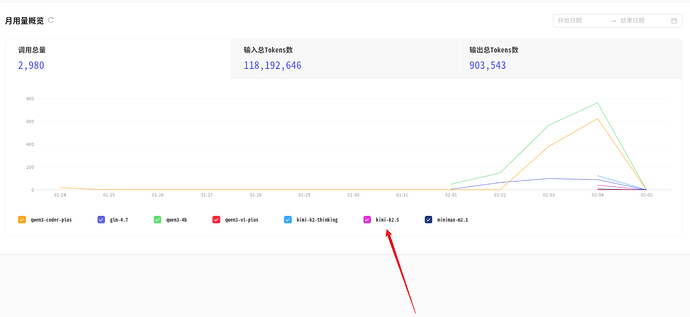

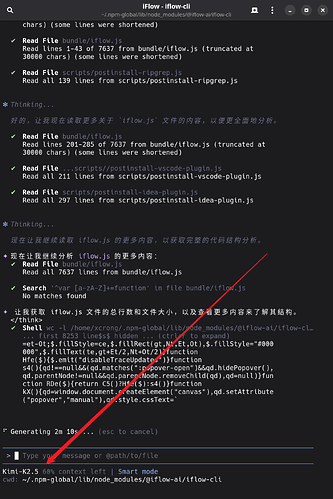

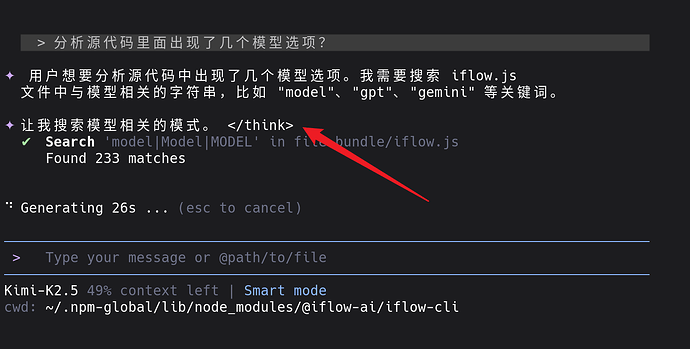

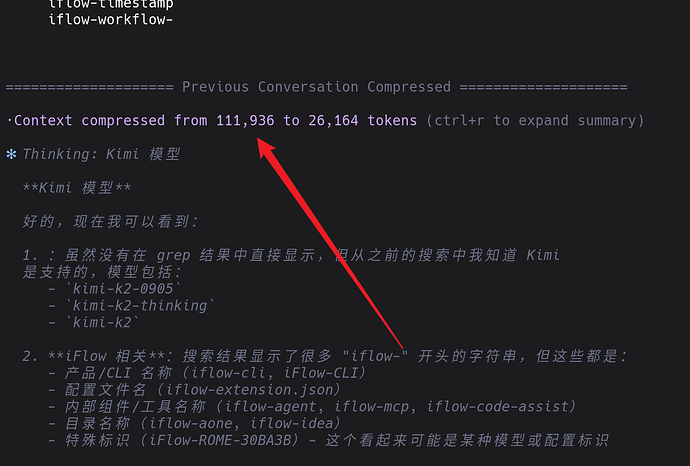

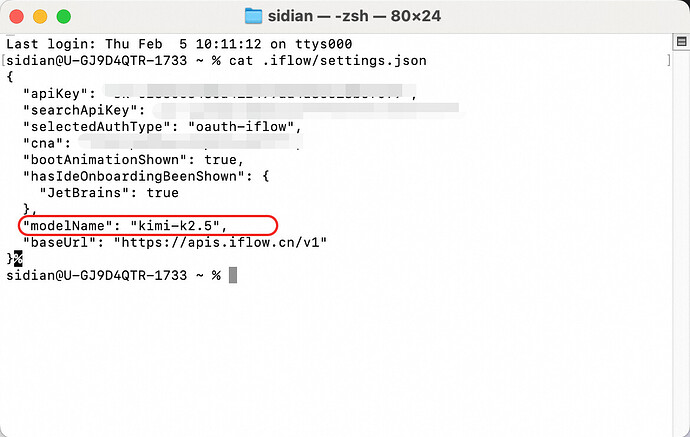

本来只是好奇,把本地 node_modules 下面的源文件,查找替换了 Kimi-K2-0905 为 Kimi-K2.5 ,我想着发布这么久了,也该上线了,不上线也该测试了。没想到真的能请求。不过似乎效果很差,工具调用用不好,应该是还没适配好,现在能用也没啥用其实。

希望后面context给长一点。128真的不够呀

是的 还在适配中,昨天没来得及上线,今天应该会通知(顺利的话)

上了吗

还没 ![]()

![]()

强,终于看到了进度条的大更新

哈哈 被发现了的感觉

开发平台用openai访问好像直接报model不支持了

会比glm4.7强吗?

现在看评测结果的话,答案是:是的

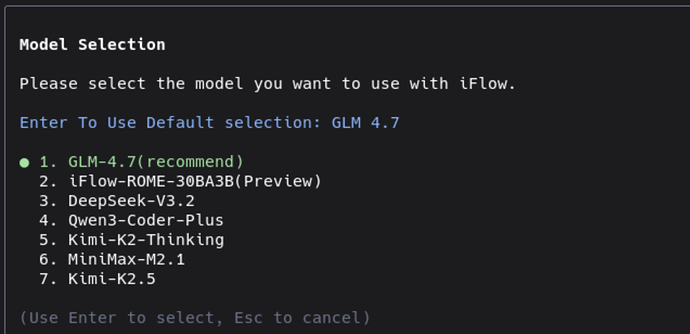

初步体验下来,目前iflow中,适配程度没有GLM4.7好,各种问题,所以体验上也没有GLM4.7好,有待提高

嗯 等适配吧。模型好,适配不行也没用。

不过现在可以用用trae或者oc上的,给iflow一点时间

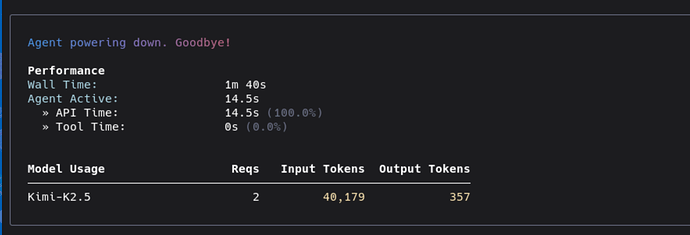

其实我担心的是速度。glm和minimax给我用爽了,但是kimi的速度估计不会太好。如果要等半天的话,体验就容易下降

用个 codex 就知道什么是慢了![]()

给就是给,不给就是不给..没必要的..大家不是啥子,

终于有动静了。